MS: I think machine learning could help in advancing semantic technologies further. One of the main issues in building semantic systems,

that they require high level human intervention i.e., building ontologies or human produced data. For example, German company DeepL,

which is providing high performing translation platform uses human translated data in mass scale with machine learning.

Semantic processing with machine learning has definitely transformed the way companies interact with customers and how they operate

in their core business.

BE: Do you think, that semantic technologies have reached a certain degree of maturity?

RB: No. By no means. If the term “semantic technologies” referring to natural language processing (NLP) and knowledge representation (KR),

there is a quite a large body of work that has already been done in academics. Unfortunately, the background required to understand these

advancements are much higher than the knowledge of today’s technology engineers, most of whom have no training in linguistics and related

fields. Therefore, technology seriously lags even to bring the current scientific advances to the surface of end usage.

BE: What is for you learning in the context of machine learning?

MS: I don’t think foundations of quantification of learning is studied enough or questioned enough in machine learning.

As Pedro Domingo puts machine learning contains lots of ‘folklore’, and what is learning in machine learning is one of them.

In research, I found amazing that actually quantification of ‘learning’ and ‘learning curves’ in machine learning originates

from Hermann Ebbinghaus’s work from early 1900s. He defined ‘forgetting curves’ over time and associates learning with memory

and experience over time. In my opinion, this is a toy model of human learning experience. A learning algorithm should be able

to show an increased performance over experience, i.e., using more data. Unfortunately, many people think a simple regression

or clustering data count as learning, which is obviously not true in naive form.

BE: Do you think that the most of databased machine learning methods and neuronal networks are black-boxes and we need knowledge-based

systems instead of them?

RB: Black-box often refers to the notion of associated memory in neural networks (NN) where information is not stored in a single neuron

(or location), instead it is distributed throughout a network. As a result, when you examine a trained neural network, you cannot

recognize any information other than the connection weights. It is a black box in the sense that you could not just reach in and

correct some information quickly, it has to be retrained with corrected data. Knowledge-based machine learning, depending on the

architecture, can be more transparent.

MS: Explainable machine learning (XAI) is one of the important goals we should have, otherwise, using black boxes blindly is really

a bad practice. On the other hand, if they are giving us practically good results, we must use them as engineering tools,

such as in computer vision to assist human decision maker. I think amalgamation of knowledge-based systems and data-driven approaches

should be utilized together, not exclusively.

BE: Can machine learning use knowledge more efficient than data? If you think it does, how can we turn data into knowledge?

RB: First of all, data-based machine learning is effective for perception, but not necessarily for learning knowledge.

For example, making sense of an image is a perception process (pattern recognition), and imagery data is suitable for neural network

application. You can apply a neural network using sound, temperature, velocity, or price data. All you will accomplish is the

perception/recognition step. However, learning the knowledge of what an image means, and how it is related to all other concepts in the

world requires knowledge-based machine learning. Knowledge is already available to us in many forms, and making use of it to generate

new knowledge is a different animal. There is a simple description I made years ago, which goes like this:

Data is the fundamental unit. Recognizing difference in data is information, recognizing difference in information is knowledge,

and recognizing difference in knowledge is logic. With this simplistic view, one can say that data-driven machine learning serves

the first chain in the link, whereas knowledge-based machine learning serves the second chain. The third chain has not yet been explored

very well.

MS: This question goes in to heart of neuroscience question of how human brain processes data and produce a knowledge based on experience.

Without understanding that we can speculate how can we build a machine learning system that even can understand what is knowledge.

For instance, machine learning approaches can really produce statistical inferences using data, but we don’t know whether resulting inferences

can be categorized as knowledge. In this direction, I would agree with Yann LeCun’s vision of understanding what is “unsupervised learning”

fundamentally may answer this question.

BE: Do you think that the human brain learns mostly from knowledge and not from data?

RB: The human brain uses data for perception, and uses perception for knowledge. If some knowledge has already been documented,

it can be reused to generate new knowledge. That’s what we do when we read books. Most of our learning is reading the existing knowledge.

Most of our creativity or judgment is to make new knowledge from what we learned.

MS: Biological system as complex as human brain is a product of millions of years of evolutionary process. For this reason,

it is well be true that it posses biologically encoded learning mechanisms that actually triggered by new knowledge rather

than purely data centric way.

BE: What are the advantages and challenges of knowledge-based learning?

RB: This is the science of knowledge representation, and creating models (ontologies) of how concepts are related to each other.

Once this majestic fountain of knowledge can be understood and used by a computer, then you have two fundamental cognitive skills

embedded in that computer: (1) understanding language at a conceptual level, and (2) making associations to generate new knowledge.

Knowledge-based learning is quite a new concept and not much done in this area so far, but it is coming.

MS: One of the main challenge is manually-building a knowledge base. They are very rigid and cannot be generalized easily.

Advantage would be they could produce highly accurate results in very specialized domain.

BE: What do you think about deep learning? Some people think it is a silver bullet…

MS: Deep learning has made of course a good progress in terms of enabling us to produce highly accurate models,

especially in computer vision. Unfortunately, it isn’t a silver bullet. But, understanding how they produce such a highly accurate model

that violates complexity measures, such as Vapnik–Chervonenkis dimension, may lead to an advancement in theoretical understand of

what is learning really is, if it is studied in the context of biological brain together. I think it has stimulate a lot of research

and it is a very good thing. We should be very sceptical about creating an attachment to a single technique emotionally.

Notice that, now deep learning loses its original meaning, and used as an umbrella term for modern machine learning research.

BE: You think, that deep learning is immature for NLP and it doesn’t good fit for chatbots?

RB: Deep learning is not immature. The problem is that some people using language as their data set do not understand the nature of

this data set. Very simple analogy is stock market data (easier to grasp). We all know stock market (price) data is incomplete to describe

the entire process. Natural language is very similar. If you take millions of pages of text as your data to train a neural network,

you are not doing anything different that taking millions of price data of stock market. Neither will result in a complete solution.

NLP encompasses all levels of “data-information-knowledge-logic” chain. Therefore, a deep learning approach has to address all levels

during training. I have not yet seen this level of approach so far, but I am sure it will come soon.

BE: Riza, you think, websites will turn soon into talk sites. What does a chatbot do that a search engine doesn’t?

RB: Search engine is a single step process of retrieving information. Chatbot is a multi-step process of retrieving information.

Multiple steps, very similar to what we do during a conversation, is obviously much more powerful technique.

However, it has many challenges. In a multi-step approach, chatbot must be able to ask questions relevant to the topic of conversation,

hence a short-term memory model is needed, and high level of pronoun tracking. Then, based on the given answers step-by-step,

chatbot should converge to an answer. Once this level of interaction is mastered by chatbots, search engines will lose their role

significantly. Most long-tail queries going into Google will start to find better responses in multi-step chatbots.

BE: In one of your papers you tell, that most of chatbots don’t use AI, but they are misrepresenting AI, how?

RB: Yes, that was referring to some chatbot platforms which require to script every single conversation one-by-one in a hard coded manner.

Devoid of any NLP detection capability, devoid of any flexible dialogue flow, devoid of any knowledge model, these chatbots do not deserve

to call themselves an AI product. I would say 90% of all platforms are serving this type of architecture. It looks easy to create a chatbot

without any AI background. Some of them will find commercial success, such as in simple banking transactions.

BE: Riza, could you tell us your exClone project shortly and the idea behind of it?

RB: exClone is a knowledge-based machine learning technology for conversational AI, which attacks the chatbot problem

in a 3 - dimensional way: (1) NLP, (2) Machine Learning, (3) Human dialogue theory. The 3rd dimension is our proprietary approach.

We are not done yet with our journey, but we have some promising light at the end of the tunnel. We called it exClone, referring to

“cloning expertise”, which is a fancy name for knowledge-based machine learning.

BE: Do you think that IBM Watson is really a success story?

RB: IBM Watson is now an empty shell, nothing but an API farm, collected from 3rd party technology vendors who agreed to highly

predatory commercial terms with IBM. We rejected their commercial terms, otherwise exClone would be in the farm. There is really

nothing to talk about Watson any more, and I quit following them for sometime.

BE: Do you think that AI will threaten human jobs, or quite the opposite so that it will create more jobs than it destroys?

MS: I think we first need to define what do we mean by AI. I think what you are referring to is “super” automation. The better question

might be, whether exponential increase in automation of many jobs and processes would lead to less or more jobs. I think this is a policy

question to our governments and policy makers, how to keep humans busy. But I think the danger of AI taking over all jobs is exaggerated.

One good example is that, since 60s, automated piloting systems are in place, but we still have pilots flying the planes.

Automation is good but human intervention may not be easily removed from the loop. We do have good advances in algorithms and robotics,

but we might be decades away to reach certain maturity in AI systems, if not at all to beat humans in general intelligence and biological

dexterity. I think we won’t see any mass unemployment just because of AI. It would be because of social issues not because of AI.

BE: Finally, a simple question about the two hottest discussion topics nowadays: Would you buy yourself a self-driving car or Bitcoin?

MS: Yes, I would use Bitcoin. If Audi releases an affordable version of their cars from ‘I, robot’ the movie, I want one of those.

RB: Commercialization of the self-driving cars begs this question: “Will you sign a disclaimer when paying thousands of dollars to buy

a car to ensure that you would not sue the company if its self-driving malfunctioned?” I will not sign it. From the legal nightmare point

of view, especially here in the US, it will never happen, same as drones. I think self-driving technology is for the military.

Bitcoin is an interesting war against the current monetary control of central banks. I am not sure how this will pan out.

I will use whatever buys me my pipe tobacco :-)

BE: Thank you all for the very interesting interview!

ABOUT

Dr. Riza Berkan is a nuclear scientist with a specialization in fuzzy logic, artificial intelligence and semantic search technologies,.

Before Dr. Berkan started exClone Inc. in 2014 he founded hakia Inc., which was an Internet semantic search engine (2004-2011).

Dr. Mehmet Süzen, originally from the island of Cyprus, completed his doctoral work at the Frankfurt Institute for Advanced Studies (FIAS)

specializing in fundamentals of statistical physics. Dr. Süzen worked at the Institute for Photonic Sciences (ICFO) in Barcelona as a postdoctoral

scientist employing modern sparse signal recovery techniques i.e. compressed sensing to optics. Dr. Süzen has been working in various academic

institutions and industries in Europe since then as a data scientist and he is active in machine learning research.

Interview

Anmerkungen zur jetzigen und künftigen Rolle von Semantik

B. Ege, Juli 27, 2017

Ein Interview mit Prof. Dr. Ulrich Schade

BE: Sehr geehrter Herr Prof. Schade. Sie sind Mathematiker und Linguist. Sie beschäftigen sich intensiv auch mit semantischen Technologien.

Sehen Sie die Zukunft in den semantischen Technologien, wenn es darum geht, nicht nur für Menschen, sondern auch für Maschinen ein

verständliches und sicheres Web, also das „Semantic Web“, aufzubauen?

US: Sehr geehrter Herr Ege, semantische Technologien können dazu beitragen, dass das Web leistungsfähiger wird. Damit meine ich,

dass für uns Menschen der Umgang mit dem Web einfacher wird und wir schneller gewünschte Ergebnisse erzielen können, also etwa bei einer

Suche die Antwort erhalten, die wir benötigen. Das ist zunächst einmal unabhängig von „Verstehen“ und von Sicherheit.

BE: Sie glauben also nicht, dass die Maschinen uns irgendwann tadellos verstehen werden? Ich meine einen Supercomputer wie der HAL 9000

im Stanley Kubricks legendären Film 2001: A Space Odyssey.

Weiterlesen...

US: Das kommt darauf an, wie wir „Verstehen“ definieren wollen. Wenn wir mit Menschen kommunizieren, können wir ja eigentlich auch nicht

sicher sein, dass sie uns „verstehen“. Wir leiten das lediglich aus den Handlungen des anderen ab. Wenn wir „Verstehen“ so definieren,

dass die Maschine in der Kommunikation und als Folge der Kommunikation „pragmatisch“ so handelt, wie wir es von einem Menschen erwarten,

ist „Verstehen“ erreichbar. Natürlich erwarten wir von der Maschine andere Ergebnisse auf eine Frage, die, wenn es um Faktenwissen geht,

genauer und ausführlicher sein sollten. Das korrekte „pragmatische Handeln“ bezieht sich also nicht auf die Ergebnisse, sondern darauf,

dass die Frage im Sinne des Fragenden beantwortet wird. Wenn ich Ihnen beispielsweise die Frage stelle „Können Sie mir sagen, wie bei Ihnen

das Wetter ist?“, erwarte ich nicht die Antwort „Ja, das kann ich.“, sondern eine Auskunft über das Wetter in Wien. Entsprechende Reaktionen

und Antworten erwarte ich von einem Computer, der mich „versteht“. Das können wir erreichen, auch bzw. insbesondere mit der Hilfe semantischer

Technologien. Will man mehr unter „Verstehen“ verstehen, ist die Diskussion eine andere, und man müsste sich dann darüber einigen,

was „mehr“ bedeutet.

BE: Sie werden sich sicher an den Sieg von IBM Watson erinnern, das sich im Jahr 2011 bei der Quizshow Jeopardy! gegenüber seinen menschlichen

Konkurrenten durchsetzen konnte. Watson ist ja in der Lage, in nur 15 Sekunden die Akten von einer Million Krebspatienten miteinander

zu vergleichen, 10 Millionen Wirtschaftsberichte und 100 Millionen Benutzeranleitungen einzulesen und zu bewerten, um anschließend

diesbezügliche Fragen sofort zu beantworten. Was halten Sie von diesem Sieg und im Allgemeinen von IBMs Projekt Watson? Sehen Sie in Watson

eine hochwertige Semantische Suchmaschine?

US: Korrekt, „Watson“ gelang ein überzeugender Sieg gegen die früheren Rekord-Sieger Ken Jennings und Bratt Rutter.

Da in der Show in natürlicher Sprache gestellte, zum Teil recht komplexe Fragen beantwortet werden mussten, und „Watson“ dies gelang,

agierte das System in dem genannten Sinn pragmatisch sinnvoll. Ich kann Ihnen zu diesem „Watson“ leider wenig sagen, aber meine Mitarbeiter

haben ein IBM-System mit der Bezeichnung „Watson Content Analytics“ (WCA) in Bezug auf dessen linguistische Fähigkeiten hin untersucht.

Das Ergebnis war sehr enttäuschend. Das darf ich vielleicht an folgendem Beispiel erläutern. Ein grundlegender Baustein der linguistischen

Analyse ist das sogenannte POS-Tagging, bei dem Wörtern ihre syntaktische Kategorie zugeordnet wird.

Wir haben die Güte des in WCA integrierten POS-Tagger durch deren Anwendung auf das sogenannte TIGERKorpus (Brants, et al., 2004) getestet.

Dieses Korpus wurde durch das Institut für Maschinelle Sprachverarbeitung der Universität Stuttgart erstellt und wird dort auch gewartet,

vgl. dazu auch http://www.ims.uni-stuttgart.de/forschung/ressourcen/korpora/tiger.html. Das Korpus besteht aus etwa 50.000 Sätzen

(900.000 Token), die Zeitungsberichten der Frankfurter Rundschau aus den Jahren 1990 bis 1994 entnommen sind.

Das Korpus enthält Annotationen zu den syntaktischen Kategorien, zur Morphologie und zu den Lemmata.

Es ist semi-automatisch annotiert und kann damit als „Goldstandard“ für POS-Tagger genutzt werden. Von den bekannten „Open Source“-POS-Taggern

erreichte der OpenNLP-Tagger (Apache OpenNLP library, http://opennlp.apache.org/) 97,5937%, der TreeTagger (Schmid, 1994) 94,9597%

und der allerdings auf dem TIGER-Korpus trainierte Tagger aus dem MateTool (Bohnet & Nivre, 2012) 99,6123%.

Die Fehler dieser Tagger betreffen im Wesentlichen Eigennamen, die nicht als Eigennamen, sondern als Nomen annotiert werden.

WCA erreichte 91,8%. Die Fehler sind zum Teil unverständlich. Im Satz „Nach einer Umfrage des Wirtschaftsmagazins Fortune unter den Bossen

von 500 Großunternehmen wünschten im Mai nur elf Prozent „Ross for President“, während 78 Prozent sich für Bush und vier Prozent für Clinton

aussprachen.“ annotiert der WCA-POS-Tagger beispielsweise „elf Prozent“ als „adjective noun“, „78 Prozent“ korrekt als „numeral noun“

und „vier Prozent“ als „determiner noun“. Da das POS-Tagging die Grundlage für die syntaktische Analyse darstellt und diese wiederum

die Grundlage der semantischen Analyse, gibt es ein Problem. Die einfachste Erklärung für das schlechte Abschneiden von WCA besteht

natürlich darin, dass WCA Algorithmen nutzt, die für das Englische entwickelt bzw. trainiert wurden und dass diese nicht auf das Deutsche

angepasst sind. Insgesamt kann ich damit leider Ihre Frage nicht durch Rückgriff auf eigene Untersuchungen beantworten.

BE: Glauben Sie an die Lernfähigkeit der Maschinen, auch wenn es sich wie eine Zukunftsmusik anhört? Was wäre der Schlüssel des Erfolges

Ihrer Meinung nach; Ontologien, Maschinelles Lernen oder sogar die Kombination der beiden? Wo liegen die möglichen Schwierigkeiten?

US: „Deep Learning“ ist, wie Sie wissen, sehr erfolgreich, etwa beim GO oder sogar beim Pokern. Der Unterschied zwischen GO und Poker

liegt dabei darin, dass beim GO alle verfügbare Information offen ersichtlich ist, was für das Pokern nicht gilt. Um erfolgreich Poker

spielen zu lernen, musste das entsprechende System auch lernen, Bluffs der menschlichen Gegenspieler einzuschätzen, was gelungen ist.

Trotzdem bieten Spiele wie GO und auch Poker den wichtigen Vorteil, dass es am Ende immer klar feststeht, wer gewonnen hat.

Daraus ergibt sich ein objektives Kriterium, das die Verfahren nutzen können. Bei der Verarbeitung von Sprache ist dieses Kriterium,

also die Information, ob die Kommunikation gelungen ist oder nicht, nicht immer verfügbar bzw. ableitbar.

Eine natürliche Sprache zu verarbeiten kann daher nicht so leicht erlernt werden. Für ein Kind ist es einfacher.

Wenn es versucht, andere mit einer Äußerung zu einer bestimmten Handlung zu bewegen, erkennt es zumeist, ob das erfolgreich war.

Wenn aber im Gegensatz dazu ein System lernen soll, sprachliche Äußerungen zu verarbeiten, und wenn es immer nur mit Anfragen

nach Informationen konfrontiert ist, erkennt nur die Person, die die Frage gestellt hat, ob ihr die Antwort genügt, nicht aber unbedingt

das System. Die Verarbeitung von einer natürlichen Sprache ist auch aus weiteren Gründen recht tückisch. In jeder Kommunikation können

beispielsweise Wörter auftreten, die sehr selten sind, so dass sie im antrainierten Sprachmodell nicht oder nur unzureichend

abgebildet sind. Als Menschen verfügen wir über Techniken, die wir dann anwenden können. Systeme wie Siri, Alexa etc. verfügen noch nicht

über diese Techniken. Vielleicht stellt die Entwicklung und Bereitstellung solcher Techniken aber den von Ihnen genannten Schlüssel dar.

Wenn die kommunikative Verständigung jedoch nicht (nur) an einer lexikalischen Lücke im Sprachmodell scheitert, sondern an fehlendem

Weltwissen, könnte auch die Nutzung von Ontologien einen Schritt in Richtung einer erfolgreichen Kommunikation darstellen.

Ich denke, die Lernfähigkeit der Systeme ist noch nicht ausgereizt, und ich denke auch, dass die Kombination von Methoden sinnvoll ist.

BE: D.h. können wir immer noch nicht über mögliche Fortschritte in den klassischen formalen Logiken sprechen, die mit unscharfem Wissen

wirklich selbstständig umgehen und selber richtige Schlussfolgerungen ziehen können. Sehen Sie in Maschinellem Lernen und Deep Learning

in dieser Form nur eine verbesserte Version von Neuronalen Netzen?

US: Es gibt Verfahren, die auch mit unscharfem Wissen arbeiten, etwa in der Sensordatenfusion. Dort werden unscharfe Sensordaten

sehr erfolgreich aggregiert. Für diese Verfahren müssen aber die Unschärfen in Form von Zahlen vorliegen. Wenn Sie aber Unsicherheit

in der sprachlichen Kommunikation erfahren, müsste zur Anwendung dieser Verfahren diese Unschärfe quantifiziert werden.

Wenn ich zum Beispiel sage: „Der Schlüssel hängt wohl an seinem Haken“, für wie hoch würden Sie die Wahrscheinlichkeit einschätzen,

dass der Schlüssel tatsächlich dort hängt?

BE: Eigentlich nicht wirklich hoch, allein deswegen, weil dabei das Adverb wohl verwendet und damit hier eine gewisse Unsicherheit

vom Anfang an doch nicht ausgeschlossen wird. Ich würde sogar intuitiv sagen, die Wahrscheinlichkeit, dass der Schlüssel an seinem Haken

liegt, beträgt in diesem Fall höchstens 50%. Diese Wahrscheinlichkeit kann sich aus meiner Sicht jedoch erhöhen oder vielleicht doch

verringern, je mehr ich diese Person, ihre Arbeitsweise/Gewohnheiten und das entsprechende Umfeld kenne. Ich kann mir aber vorstellen,

diese Sicherheit/Unsicherheit, die ich als Mensch intuitiv erfassen und bis zu einem gewissen Grad sogar in Zahlen leicht ausdrücken kann,

für die Maschinen sicherlich nicht so leicht quantifizierbar wäre.

US: Dem kann ich nur zustimmen, evtl. mit der Abweichung, dass ich die Wahrscheinlichkeit höher, etwa mit 60% einschätzen würde.

Aber wie Sie richtig ausgeführt haben, kann sich die Einschätzung ändern, wenn man mehr über den situativen Kontext weiß.

In jedem Fall stimme ich zu, dass für ein System das Problem darin liegt, dass es ein Wissen über die Welt und über den situativen Kontext,

welches wir für unsere Einschätzungen ausgewertet haben, wenigsten zum Teil nicht repräsentiert hat. Die Beantwortung der Frage nach dem

möglichen Fortschritt hängt somit auch damit zusammen, ob es gelingen kann, solches Wissen über den menschlichen Alltag in einem System

so zu repräsentieren, dass es nutzbar wird. Dies ist vielleicht mit einer Art „Deep Learning“ möglich. Zu „Deep Learning“ würde ich,

an Ihre vorherige Frage anschließend gerne noch sagen, dass es aus meiner Sicht natürlich auf den Erkenntnissen beruht, die wir ausgehend

von Frank Rosenblatts Perceptron – Rosenblatt, Frank (1958): The perceptron: a probabilistic model for information storage and organization

in the brain. Psychological Reviews 65 (1958) 386-408 – über die sogenannten Neuronalen Netze angehäuft haben.

Im Vergleich zu den 1980er-Jahren (Error Backpropagation und RNNs) haben wir schnellere Rechner, sehr viel mehr Daten, auf denen die

Lernverfahren aufsetzen können, aber mit den neueren Arbeiten, etwa von Geoffrey Hinton, auch algorithmische Fortschritte.

BE: Sie hatten gesagt, dass man unterschiedliche Verfahren kombinieren sollte, um zu weiteren Fortschritten zu gelangen.

Wir haben dann über „Deep Learning“ gesprochen, die man zu den statistik-basierten Verfahren zählen kann.

Ich würde nun gern noch kurz auf die andere Seite der Kombination eingehen, auf die regel-basierten Verfahren und auf Ontologien,

in denen Wissen formal repräsentiert wird. Man hört in letzter Zeit öfters neben Triple-Stores für diese Repräsentation auch

von Quadrupelstores, in dem nicht nur Triples, sondern für jedes Tripel zusätzliche Metadaten wie Zeitbereichsinformationen etc.

gespeichert werden können. Was halten Sie von Quadrupeln anstatt von Tripeln? Finden Sie die Quadrupel möglicherweise noch flexibler

und ausdrucksstärker? Glauben Sie, dass Triple Stores langfristig durch Quadrupelstores doch obsolet werden?

US: Ein Tripel ist letztlich eine Kombination aus einem „Subjekt“, einer „Relation“ und einem „Objekt“.

Solche Relationen sind für die Repräsentationen von Wissen außerordentlich nützlich. Nehmen wir einmal die Aussage

„Berlin ist die Hauptstadt von Deutschland“, so wird klar, dass wir als Menschen unbewusst ein „jetzt“ hinzufügen.

In manchen Kontexten kann aber eine explizite zeitliche Verortung nützlich sein, welche man, wie Sie ja andeuten,

über Quadrupel realisieren könnte. Ich möchte hier aus sprachlicher Sicht argumentieren, dass eine flexiblere Repräsentation

möglicherweise sinnvoll ist. Aus einer formalen linguistischen Sicht heraus, kann man die meisten sprachlichen Aussagen (Sätze)

mit einer kontextfreien Grammatik generieren. Kontextfreie Grammatiken lassen sich auf die Chomsky-Normalform bringen, die neben Regeln

zur Ersetzung eines nichtterminalen Symbols durch ein terminales Symbol Produktionsregeln der Form „A-->BC“ enthalten.

Diese Regelform entspricht der Repräsentation durch Tripel. Die Frage ist nun, ob die Repräsentation durch Tripel nicht nur theoretisch

immer möglich, sondern für eine spezifische Anwendung auch angemessen ist. Ich kann versuchen, auch das an sprachliche Aussagen zu

erläutern. Sprachliche Aussagen enthalten Relationen, aber unterschiedliche Anzahlen von Argumenten. „Es schneit“ kann nicht einfach

so als Standardtripel dargestellt werden. Bei „Maria lacht“ kann man „Maria“ als Subjekt repräsentieren, wobei dann aber das Objekt fehlt.

Als Sprecher der samoanischen Sprache jedoch würden Sie in „Maria“ das Objekt von „lacht“ sehen, wobei dann das Subjekt fehlt.

Bei komplexeren Sätzen, etwa treten zahlreiche Konstituenten, nicht nur Zeitangaben, auf, die Sie dann auch irgendwie repräsentieren müssen.

In dem Satz „The company advanced from Wilderness Church via Dowdall’s Tavern towards Chancellorsville” gibt es etwa drei Konstituenten,

über die die durchgeführte Bewegung geographisch und nicht zeitlich präzisiert wird. Es wäre zu diskutieren, wie das geeignet repräsentiert

werden kann bzw. für welche Anwendungen Tripel bzw. Quadrupel eine geeignete und angemessene Repräsentationsform darstellen

und für welche sie unpraktisch und irreführend sind.

BE: Stellen die Ontologien Ihrer Meinung nach eine der elegantesten Lösungen für die Suchmaschinen dar? Können viele Probleme der Suche

durch die Verwendung von Ontologien tatsächlich viel einfacher und effizienter gelöst werden? Glauben Sie, dass die Zukunft der Suche

in der semantischen Suche mit Ontologien liegt?

US: Auch dies ist eine Frage der Anwendung. Man muss sich zunächst die Frage stellen, wofür die Suche genutzt werden soll.

Sollen etwa bei einem vorgegebenen Begriff Webseiten gefunden werden, die sich auf das beziehen, was der Begriff denotiert,

so kann es genügen, wenn auch die Vorkommen von Synonymen und Hyponymen (Unterbegriffe) zu dem vorgegebenen Begriff gefunden werden.

In dem Fall benötigt man keine vollständige Ontologie des betreffenden Gegenstandsbereichs, sondern „nur“ eine Taxonomie dazu,

deren Erstellung weniger Aufwand erfordert.

BE: Im Kapitel 16 „Ontologien als Schlüsseltechnologie für die automatische Erzeugung natürlichsprachlicher Texte“ des Buchs

Corporate Semantic Web stellen Sie auch dar, wie semantische Technologien in den Bereichen SEO und automatische Textgenerierung

angewendet werden können. Glauben Sie, dass man gerade in diesen Bereichen in den nächsten Jahren mit steigendem Einsatz

der semantischen Technologien rechnen kann?

US: Ja. Mein Kollege und Freund Hermann Bense zeigt mit seiner Firma textOmatic, wie gut die automatisierte Textgenerierung

schon gelingen kann, selbst für eine Sprache wie Deutsch ☺, wenn es darum geht, strukturiert vorliegende Informationen sprachlich

auszudrücken. Sie können dies jederzeit ansehen, da textOmatic die Online-Seite von Focus automatisiert erstellte

und stets sehr aktuelle Wetterberichte und der Online-Seite des Handelsblatts ebenso aktuelle Börsenberichte zur Verfügung stellt.

Um die Qualität dieser Berichte noch zu verbessern, benötigt man semantische Technologien. Aber das im Detail zu erläutern würde

wohl ein weiteres Interview ergeben.

BE: Also können wir zusammenfassend sagen, dass die semantische Interpretation der natürlichen Sprachen für die Maschinen auch zukünftig

eine echte Herausforderung ist und bleibt, ganz zu schweigen von der Interpretation von menschlichen Emotionen, welche spätestens

mit Internet of Things (IoT) sicherlich noch mehr an Bedeutung gewinnen wird. Außerdem haben wir uns hier nochmals klargemacht,

neben Technologien wie „Maschinelles Lernen“ und „Deep Learning“ wie aktuell immer noch „Ontologien“ sind und zwar für die Zukunft

unserer Gesellschaft und das zukünftige Web nämlich Semantic Web. Sehr geehrter Herr Prof. Schade, ich bedanke mich bei Ihnen im Namen

unserer Arbeitsgruppe Semantic Web vielmals für dieses ausführliche und nette Gespräch.

ÜBER

Apl. Prof. Dr. Ulrich Schade studierte Mathematik (Diplom, 1986) und Linguistik (Promotion, 1990. Habilitation für Computerlinguistik

und Psycholinguistik, 1996). Nach Lehrstuhlvertretungen in Bielefeld und Stuttgart arbeitet er seit 2002 als Forschungsgruppenleiter

für Informationsanalyse am Fraunhofer-Institut für Kommunikation, Informationsverarbeitung und Ergonomie. Daneben lehrt er an der

Rheinischen Friedrich-Wilhelms-Universität im Bereich „Applied Linguistics“. Er ist Autor von zahlreichen wissenschaftlichen Artikeln.

Auch im Buch Corporate Semantic Web veröffentlichte er zwei hochinteressante Beiträge direkt aus der Praxis: Semantische Suche im Bereich

der Energieforschungsförderung (U. Schade, H. Bense, M. Dembach, L. Sikorski) und Ontologien als Schlüsseltechnologie für die automatische

Erzeugung natürlichsprachlicher Texte (U. Schade, H. Bense).

Marktstudie:

Welche Standards und Tools werden in Unternehmen eingesetzt?

Book Chapters

B. Ege, Februar 21, 2016

Auszug aus dem Buch Corporate Semantic Web*

Im Fokus dieses Beitrags Marktstudie: Welche Standards und Tools werden in Unternehmen eingesetzt? (B. Ege) stehen Semantic Web Projekte,

die für den Einsatz in verschiedenen Bereichen entwickelt wurden. Der Beitrag wurde im Buch Corporate Semantic Web (Hrsg. B. Ege et al.,

Springer-Verlag, 2015) veröffentlicht. Die meisten der im Beitrag dargestellen Semantic Web Projekte sind bereits in der Produktion,

d.h. reale Anwendungen mit echten Nutzern. Auf die Kundenanforderungen für jedes Projekt folgen dann auch die dazugehörigen technischen

Lösungen bzw. die Architektur der Anwendungen und anschließend die bisherigen Erfahrungswerte der Firmen im Umgang mit verwendeten

Semantic Web Standards und Tools. Gegen Ende des Beitrags erwartet den Leser die Ergebnisse einer Umfrage mit weiteren Tipps und Hinweisen,

dann ein Ausblick und zum Schluss eine Liste von aktuellen Semantic Web Standards und Tools. Die Darstellung von insgesamt vier Semantic Web

Projekten und die Ergebnisse einer Umfrage im Rahmen dieses Beitrags geben einen kleinen Einblick in die Welt der Hersteller von

Semantic Web-Anwendungen. Die einzelne Beschreibungen der Kundenanforderungen in Projekten, die dazugehörigen technischen Umsetzungen

wie die entwickelten Architekturen, verwendete Standards, und Tools, sowie konkrete Umsetzungshinweise erweitern den Horizont der Leser

zusätzlich.

Einige Ergebnisse der Marktstudie

- SKOS ist meistens die erste Wahl bei der Erstellung von Thesauri.

- Semantic Web Anwendungen beginnen, in der Industrie in verschiedenen Bereichen Fuß zu fassen.

- W3C Standards genießen sowohl bei den Software-Herstellern als auch bei Kunden eine hohe Akzeptanz.

- Hybride Semantic Web-Anwendungen sind die de facto Standard-Lösungen, da ein sehr großer Anteil der Daten immer noch in relationalen Datenbanken gespeichert ist.

- Die Bedeutung von semantischen Technologien werden in Zukunft sowohl im Bereich Big Data als auch in der Industrie 4.0 zunehmen, da sie die Integration und somit die Interoperabilität vereinfacht.

*Corporate Semantic Web - Wie semantische Anwendungen in Unternehmen Nutzen stiften, Hrsg. B. Ege et al.,

Kapitel 3: Marktstudie: Welche Standards und Tools werden in Unternehmen eingesetzt? (B.Ege), Springer-Verlag, Juni 2015.

Buchvorstellung - Corporate Semantic Web

Semantic Events

B. Ege, Februar 21, 2016

Freie Universität Berlin, Computer Science Department

Corporate Semantic Web Group

Königin-Luise-Str. 24/26, 14195 Berlin

30. März 2016, 18:15 Uhr

Was bedeutet das Corporate Semantic Web? Was bedeutet eine semantische Anwendung? Wie und womit wird es erstellt?

Welche Standards und Tools werden eingesetzt? Und vor allem: Warum gibt es eigentlich kaum Literatur zu Corporate Semantic Web Anwendungen?

Semantic Web ist keine Zukunftsmusik mehr, und dass es bereits solche Anwendungen gibt, wissen wir aus eigener Projekterfahrung.

Zum einen gibt es bereits zahlreiche solcher Anwendungen; zum anderen suchen viele nach Hinweisen, Tipps und Tricks zur Entwicklung derselben.

Aber trotz der hohen Aufmerksamkeit für Themen rund um das Semantic Web, trotz vieler Artikel und Bücher zu Grundlagen, Standards, Werkzeugen

und Visionen, gibt es kaum Literatur, die Architekten, Projektleiter, Ontologie-Modellierer oder Entwickler semantischer Anwendungen bei ihrer

Arbeit unterstützt. So war die Idee zum Buch Corporate Semantic Web geboren. Mit unserem Buch möchten wir den Blick weiten

und auch semantische Anwendungen einbeziehen, die in Organisationen aller Art eingesetzt werden. Es geht also um reale Anwendungen

für relevante Anwendungsfälle mit echten Anwendern. Vorgestellt werden Anwendungen aus verschiedenen Branchen wie Telekommunikation,

Logistik, Energie, Medizin, Verlagswesen sowie eine Marktstudie. Die Teilnehmer erhalten somit einen umfassenden Überblick über die

Einsatzbereiche des Semantic Web sowie konkrete Umsetzungshinweise für eigene Vorhaben.

Im Rahmen des Meetups stellt Börteçin Ege sein Buchprojekt vor.

Was bedeutet das Corporate Semantic Web? Was bedeutet eine semantische Anwendung? Wie und womit wird es erstellt?

Welche Standards und Tools werden eingesetzt? Und vor allem: Warum gibt es eigentlich kaum Literatur zu Corporate Semantic Web Anwendungen?

Semantic Web ist keine Zukunftsmusik mehr, und dass es bereits solche Anwendungen gibt, wissen wir aus eigener Projekterfahrung.

Zum einen gibt es bereits zahlreiche solcher Anwendungen; zum anderen suchen viele nach Hinweisen, Tipps und Tricks zur Entwicklung derselben.

Aber trotz der hohen Aufmerksamkeit für Themen rund um das Semantic Web, trotz vieler Artikel und Bücher zu Grundlagen, Standards, Werkzeugen

und Visionen, gibt es kaum Literatur, die Architekten, Projektleiter, Ontologie-Modellierer oder Entwickler semantischer Anwendungen bei ihrer

Arbeit unterstützt. So war die Idee zum Buch Corporate Semantic Web geboren. Mit unserem Buch möchten wir den Blick weiten

und auch semantische Anwendungen einbeziehen, die in Organisationen aller Art eingesetzt werden. Es geht also um reale Anwendungen

für relevante Anwendungsfälle mit echten Anwendern. Vorgestellt werden Anwendungen aus verschiedenen Branchen wie Telekommunikation,

Logistik, Energie, Medizin, Verlagswesen sowie eine Marktstudie. Die Teilnehmer erhalten somit einen umfassenden Überblick über die

Einsatzbereiche des Semantic Web sowie konkrete Umsetzungshinweise für eigene Vorhaben.

Im Rahmen des Meetups stellt Börteçin Ege sein Buchprojekt vor.

CORPORATE SEMANTIC WEB

Semantic Bücher

B. Ege, Juli 7, 2015

Herausgeber: B. Ege et al.

Umfang: 403 Seiten

Verlag: Springer Vieweg

Erscheinungstermin (Hardcover/eBook): Juni 2015

„Warum gibt es eigentlich kaum Literatur zu semantischen Anwendungen, die in Unternehmen Nutzen stiften?“ Dass es bereits solche

Anwendungen gibt, wissen wir aus eigener Projekterfahrung. Aber gerne hätten wir unsere Erfahrungen mit anderen ausgetauscht,

die auch bereits erfolgreich semantische Anwendungen für und mit Unternehmen und deren Mitarbeitern und Kunden entwickelt haben.

Als Moderatoren der XING-Arbeitsgruppen „Semantic Web“ (3500 Mitglieder) und „Ontologien in den Informationswissenschaften“

(1250 Mitglieder) streckten wir unsere Fühler aus: Das Feedback war enorm. Zum einen gibt es bereits zahlreiche solcher Anwendungen;

zum anderen suchen viele nach Hinweisen, Tipps und Tricks zur Entwicklung derselben. Aber trotz der hohen Aufmerksamkeit für Themen

rund um das Semantic Web, trotz vieler Artikel und Bücher zu Grundlagen, Standards, Werkzeugen und Visionen, gibt es kaum Literatur,

die Architekten, Projektleiter, Ontologie-Modellierer oder Entwickler semantischer Anwendungen bei ihrer Arbeit unterstützt.

So war die Idee zu unserem Buch „Corporate Semantic Web – Wie semantische Anwendungen in Unternehmen Nutzen stiften“ geboren.

Corporate Semantic Web – im engeren Sinne bedeutet dies Semantic Web Anwendungen, welche innerhalb eines Unternehmens verwendet werden.

Mit unserem Buch möchten wir den Blick weiten und auch semantische Anwendungen einbeziehen, die in Organisationen aller Art – kommerziell

und nicht kommerziell – eingesetzt werden, nicht nur von Mitarbeitern, sondern auch von Kunden oder Partnern. Es geht also um reale

Anwendungen für relevante Anwendungsfälle mit echten Anwendern. Die Autoren, namhafte Experten aus Industrie und Wissenschaft,

berichten über ihre Erfahrungen bei der Entwicklung solcher Anwendungen. Sie gehen auf Software-Architektur, Methodik, Linked Open Data Sets,

Lizenzfragen und Technologieauswahl ein und präsentieren auch eine Marktstudie. Vorgestellt werden Anwendungen für die Branchen

Telekommunikation, Logistik, verarbeitende Industrie, Energie, Medizin, Tourismus, Bibliotheks- und Verlagswesen sowie Kultur.

Der Leser erhält so einen umfassenden Überblick über die Einsatzbereiche des Semantic Web sowie konkrete Umsetzungshinweise für eigene Vorhaben.

Battle Management Language (BML)

Semantic News

U. Schade und B. Ege, Juni 20, 2015

Führung von heterogenen Mehrrobotersystemen mittels Battle Management Language (BML)

|

| Foto: Fraunhofer FKIE |

Ontologien finden nicht nur in Unternehmen, sondern auch in militärischen Bereichen Anwendungen. Ein gutes Beispiel dafür

ist die Battle Management Language (BML) eine formale Sprache ohne Mehrdeutigkeiten, aber mit großer Ausdrucksstärke.

BML wurde im Rahmen der NATO (vgl. Coalition Battle Management Language) entwickelt und von der Simulation Interoperability

Standards Organization als Standard anerkannt. Die Sprache BML stützt sich ab auf das NATO-Datenmodell JC3IEDM, welches als Fachontologie

für militärische Operationen angesehen werden kann und über welches die in BML verwendeten Terme (Wörter) in ihrer Bedeutung festgelegt

sind. Das bringt viele Vorteile mit. Durch Verwendung von BML können bspw. in militärischen Bereichen alle Systeme

(unbemannte Systeme, Simulationssysteme und Command & Control Systeme) die in BML formulierten Befehle und Meldungen inhaltlich

„verstehen“ bzw. verarbeiten und nutzen. Außerdem kann BML in multinationalen Operationen als Lingua Franca zwischen den beteiligten

Organisationen genutzt werden, um Interoperabilität zwischen verschiedenen Organisationen zu erhöhen.

Die derzeit wichtigste Anwendung der BML ist die Befehligung von simulierten Einheiten und unbemannten Systemen aus einem

Command & Control System (C2-System) heraus. Dadurch lassen sich Simulationssysteme etwa in der Ausbildung von Offizieren nutzen,

wobei die auszubildenden Offiziere ihre (simulierten) Truppen über ihr C2-System führen, ganz so wie sie auch reale Einheiten führen.

Ein weitere Anwendung stellt die Befehligung von Mehrrobotersystemen mittels BML dar. Aus BML kann auch eine zivile Variante entwickelt

werden, die sich für die Kommunikation in Einsätzen der zivilen Sicherheit eignet, um die Interoperabilität zwischen den beteiligten

Organisationen (Polizei, Feuerwehr, THW, Militär, weitere NGOs) zu erhöhen und die Einbindung von den unterschiedlichen

Führungs- und Logistiksystemen dieser Organisationen zu optimieren. Auf der Homepage von Fraunhofer FKIE können Sie über BML mehr erfahren und sich auch ein Video anschauen, wie BML-Befehle von Robotern

umgesetzt werden. Das Video wurde 2013 auf dem Gelände der Bundeswehr in Hammelburg gedreht. Es zeigt, wie mit der Hilfe einer

GUI Befehle in BML eingegeben werden können und wie diese von einem Team Unbemannter Systeme umgesetzt werden.

WORKSHOP 2015

CORPORATE SEMANTIC WEB

Semantic Events

B. Ege, Februar 02, 2015

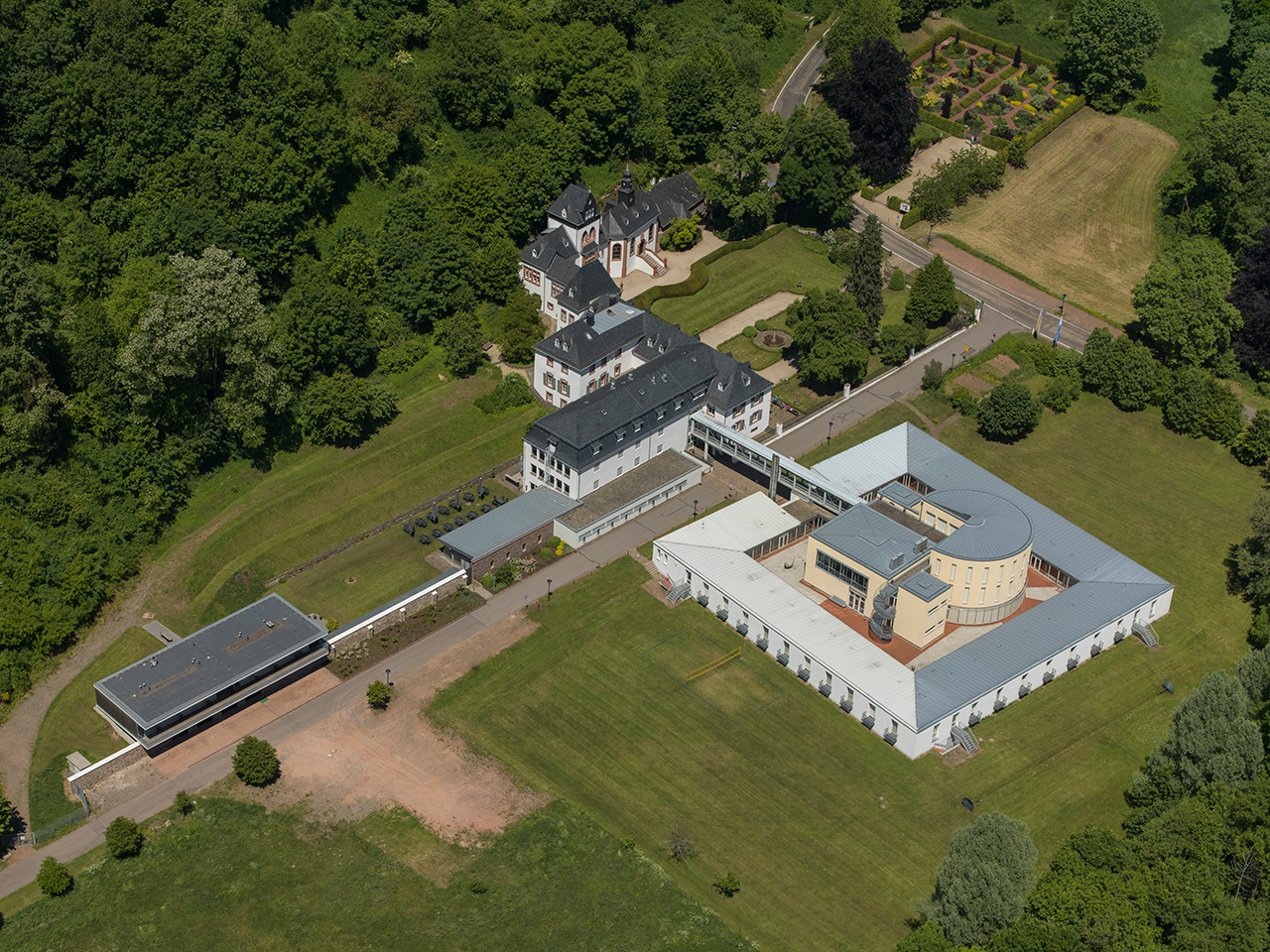

Nachfolge-Workshop zum Buchprojekt „Corporate Semantic Web“

Juni 15-17, 2015, Schloss Dagstuhl (Leibniz-Zentrum für Informatik), Wadern, Saarland, Deutschland

|

| Foto: Schloss Dagstuhl - Leibniz-Zentrum für Informatik |

Auch dieses Jahr findet ein Workshop zum Thema Corporate Semantic Web statt, welches ein Nachfolge-Workshop zum Buchprojekt

Corporate Semantic Web ist. Unter den Teilnehmern befinden sich ein großer Teil der Mitautoren des Buchs Corporate Semantic Web,

welches in Mai 2015 bei Springer-Verlag erscheinen wird. Der Workshop findet von 15 Juni bis 17 Juni 2015 im Schloss Dagstuhl

(Leibniz-Zentrum für Informatik) in Wadern (Saarland) in Deutschland statt. Im Workshop sollen semantische Anwendungen besprochen

werden, die bereits heute in Unternehmen Nutzen stiften. Ein weiteres Ziel des Workshops ist es, eine Community von Praktikern

zu etablieren, die ihre Erfahrungen in der Entwicklung semantischer Anwendungen austauschen.

Dabei wird für vielfältige Themenstellungen Raum sein, z.B.:

- Wie können Projekte zur Entwicklung semantischer Anwendungen akquiriert und durchgeführt werden?

- Welche Technologien haben sich in der Praxis bewährt, welche nicht?

- Welche methodischen und rechtlichen Fragen sind relevant?

- Wie vermarkten wir unsere Lösungen und Anwendungen erfolgreich?

- Wie zeigen und sichern wir die Qualität unserer Lösungen und Anwendungen?

Die offizielle Dagstuhl-Webseite zum Workshop (2015)

Industrie 4.0

Semantic News

B. Ege, Juni 29, 2014

Die 4. industrielle Revolution steht bevor

Eine vierte Industrie Revolution steht der Welt bevor, zumindest auf lange Sicht. Die bevorstehende industrielle Revolution heißt

Industrie 4.0. Mit der Industrie 4.0 werden neue Produktionsmethoden eingeführt, die bisher nicht möglich waren.

Weltweit planen die größten Elektrokonzernen noch heute, ihre Produktionsmethoden Schritt für Schritt auf Industrie 4.0 umzustellen.

Bei Industrie 4.0 handelt es sich um Intelligente Fabriken, die Produkte höchst autonom herstellen können. Um diesen Zweck zu erreichen,

müssen jedoch vor allem die Produktionsmaschinen und deren Produkte untereinander vernetzt werden können.

Das ist jedoch nur durch den Einsatz der semantischen Technologien erreichbar. Denn ohne semantische Interoperabilität

der Maschinen ist eine intelligente Produktion nicht realiserbar. Man erwartet jedoch, dass die Realiserung solcher Systeme

noch dauern wird. Vermutlich werden die ersten Industrie 4.0-Produkte erst in den 2020’er Jahren die Fließbänder verlassen.

Kernideen der Industrie 4.0

- Mit der Industrie 4.0 beginnt das auf den einzelnen Kundenbedarf zugeschnittene Produktionszeitalter

- Höchst autonome Produktion von sehr komplizierten Produkten durch die Maschinen

- Vernetzung der Produktionsmaschinen untereinander, wobei die Maschinen mit hergestellten Produkten auch nach der Produktion in Verbindung bleiben. Auch die Produkten halten ihre Historie im "Gedächtnis"

- Mit der neuen Version der Internet Protocol IPv6 ist die technische Infrastruktur fürs 'Internet der Dinge' (Internet of Things) bereits geschafft

- Auch im Industrie 4.0-Zeitalter unterstützen die Maschinen den Alltag weiterhin massiv jedoch ohne aufzufallen oder wahrgenommen zu werden (Embedded). Dieser Schritt erfordert jedoch die Entwicklung von preiswerten Hardware, die möglichst klein sind und ohne viel Wärme abzugeben und zugleich hochsicher arbeitet. Somit fängt auch die Ära von Cyber Physical Systems (Das Hardware-Rückgrat der Industrie 4.0)

- Semantische Technologien sind der Kern der Industrie 4.0, weil ohne sie, die semantische Interoperabilität weder unter Produktionsmaschinen untereinander noch zwischen Produkten und Produktionsmaschinen nicht gewährleistet werden kann. (Das Software-Rückgrat der Industrie 4.0)

Quelle: 4. Endüstri Devrimi (Industry 4.0), Börteçin Ege, TÜBİTAK Bilim ve Teknik, S.26-29, Mai 2014

WORKSHOP 2014

CORPORATE SEMANTIC WEB

Semantic Events

B. Ege, Februar 07, 2014

Workshop zum Buchprojekt „Corporate Semantic Web“

Juni 25-27, 2014, Schloss Dagstuhl (Leibniz-Zentrum für Informatik), Wadern, Saarland, Deutschland

|

| Foto: Schloss Dagstuhl - Leibniz-Zentrum für Informatik |

"Warum gibt es eigentlich kaum Literatur zu semantischen Anwendungen, die in Unternehmen Nutzen stiften?"

Mit dieser Frage wurde das Buchprojekt Corporate Semantic Webbim November 2013 geboren. Denn trotz der hohen Aufmerksamkeit

für Themen rund um Semantic Web, trotz vieler Artikel und Bücher zu Grundlagen, Standards, Werkzeugen und Visionen,

gibt es kaum Literatur, die Architekten, Projektleiter, Ontologie-Modellierer oder Entwickler semantischer Anwendungen

bei ihrer Arbeit unterstützt. Das Buch setzt an diesem Punkt an.

Um über ihre Beitragsschwerpunkte, den Stand der Technik im Bereich Semantic Web und ihre offenen Fragen bezüglich des Buchprojekts

zu diskutieren und auszutauschen, treffen sich die Autoren und die Herausgeber vom 25. bis 27. Juni 2014 im Schloss Dagstuhl.

Sie werden im Rahmen des Workshops dem Buch den inhaltlichen Schliff geben. Im Fokus dieses ersten Workshops stehen insbesondere

die Vorstellung und inhaltliche Diskussion der Kernaussagen der Beiträge zum Buch. Damit soll sichergestellt werden, dass sie

zueinander stimmig und passend sind. Außerdem sollen mögliche Verständnisfragen geklärt werden, um bspw. vermeintliche Widersprüche

aufzudecken.

Weitere Themen zum Workshop

- Redaktionelle Fragen

- Erstellung eines Zeitplans

- Planung der Reihenfolge und Zuordnung der Beiträge

- Feststellung der Abhängigkeiten unter den Beiträgen

- Wer hat was zu tun?

- Wie geht's weiter?

Die offizielle Dagstuhl-Webseite zum Workshop (2014)